AI 혁명은 우리에게 달려 있지만 과거의 변위 변화와 달리 우리 대부분은 클라우드에서 가장 고급 버전의 AI 모델과 통신합니다. Chatgpt, Claude 및 Gemini와 같은 주요 서비스는 클라우드 기반으로 남아 있습니다. 그러나 개인 정보 보호, 연구 및 제어를 포함하는 이유는 로컬로 시작한 AI 모델은 여전히 흥미롭고 GPU 및 NPU를 통해 클라이언트 시스템의 AI 성능을 안정적으로 중립적으로 측정 할 수 있어야합니다.

하드웨어 및 소프트웨어 공급 업체는 로컬 실행에 가장 적합한 작업 부하 유형과 실행되는 리소스의 가장 적합한 계산을 정의하기 위해 AI 클라이언트가 매우 유동적 인 공간으로 남아 있습니다. 이 빠르게 변화하는 환경에서 이동하기 위해 MLCommons 컨소시엄과 MLPERF 클라이언트 작업 그룹은 주요 하드웨어 및 소프트웨어의 주요 공급 업체와 협력하여 개발 된 클라이언트의 참조 가치를 유지합니다.

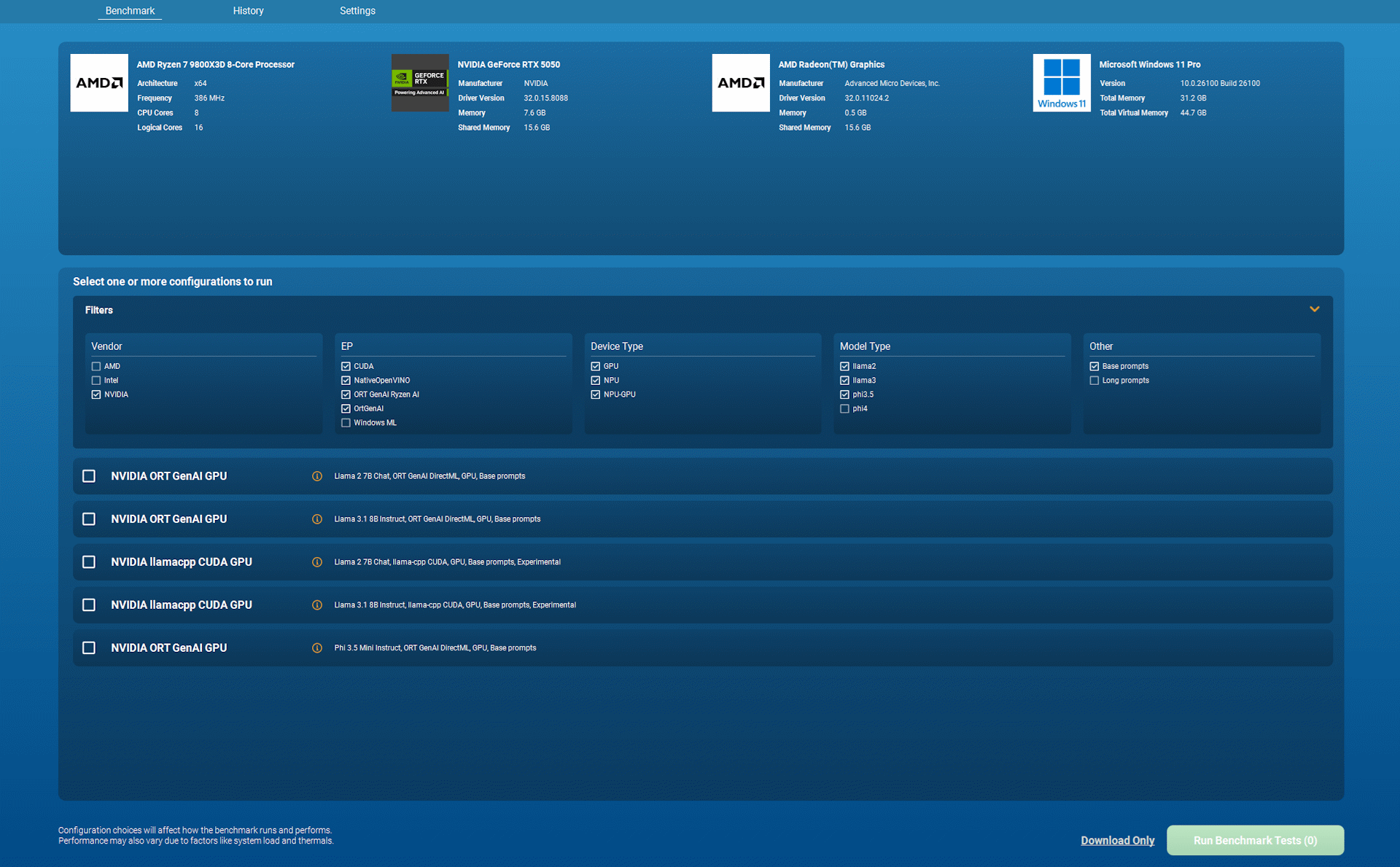

MLPERF Client 1.0은 이전 버전 0.6의 참조 값보다 일부 주요 개선 사항으로 게시되었습니다. 이 새로운 도구에는 더 많은 AI 모델이 포함되어 있으며 여러 공급 업체의 하드웨어 가속을 지원하며 대형 언어 모델과의 더 넓은 범위의 사용자 상호 작용을 테스트합니다. 또한 더 많은 캐주얼 사용자를 위해이 테스트의 매력을 확장 해야하는 유용한 그래픽 인터페이스가 있습니다.

MLPERF 클라이언트 1.0은 이제 Meta Llam 2 7B 채팅 및 LLAM 3.1 8B 모델 유도 및 Microsoft의 PHI 3.5 Mini Inctuct로 성능을 테스트 할 수 있습니다. 또한 14B 모델의 PHI 4 설명의 실험 모델에 대한 지원을 제공합니다.

MLPERF Client 1.0은 또한 더 넓은 범위의 빠른 종에서의 성능을 탐색합니다. 그는 현재 개발자가 일반적으로 오늘 찾을 수 있으므로 코드 분석의 성능을 조사합니다. 또한 실험 기능으로 4000 또는 8000 토큰의 큰 컨텍스트 Windows를 갖춘 컨텐츠 요약의 성능을 측정 할 수 있습니다.

이 모델 범위와 컨텍스트 크기는 여러 장치에서 확장 가능한 작업 부하 세트와 같은 하드웨어 검사관을 제공합니다. 예를 들어,이 판의 일부 실험 하중에는 16GB의 VRAM이있는 GPU가 필요하므로 통합 그래픽 및 NPU뿐만 아니라 고급 하드웨어를 강조 할 수 있습니다.

하드웨어 및 소프트웨어 시리즈 클라이언트 AI 시리즈는 유동적이며 로컬로 작업 하중을 가속화 할 수있는 다양한 방법은 솔직히 현기증입니다. MLPERF 클라이언트 1.0은 주로 Qualcomm 및 Apple 장치의 경우보다 여러 하드웨어의 이러한 가속도 트레일을 더 많이 다룹니다. 지원되는 경로 목록은 다음과 같습니다.

- Onnx 런타임 Genai 및 Ryzen AI SDK를 통한 AMD NPU 및 GPU 하이브리드 지원

- Onnx 런타임 Genai-DirectML을 통한 AMD, Intel 및 Nvidia GPU 지원

- OpenVinoa를 통한 인텔 NPU 및 GPU 지원

- Qualcomm Genie 및 Qairt SDK를 통한 NPU 및 CPU 하이브리드 지원 NPU 및 CPU 하이브리드 지원

- MLX를 통한 Apple Mac GPU 지원

버전 1.0 참조 값은 하드웨어 실행의 이러한 실험 트레일을 지원합니다.

- Microsoft Windows ML 및 OpenVino 서비스 제공 업체를 통해 Intel NPU 및 GPU 지원

- llam.cpp-cuda를 통한 NVIDIA GPU 지원

- LLAM.CPP-Metal을 통한 Apple Mac GPU 지원

마지막으로 가장 중요하지는 않지만 MLPERF Client 1.0은 이제 사용 가능한 그래픽 사용자 인터페이스를 가지고있어 사용자가 하드웨어에서 시작하여 쉽게 선택할 수있는 모든 참조 값 범위를 이해할 수 있습니다.

GUI 버전은 또한 다양한 실시간 하드웨어 리소스의 모니터링을 제공하므로 언뜻보기에 선택한 실행 경로가 예상되는 GPU 또는 NPU에 의해 수행되는지 확인할 수 있습니다.

MLPERF 클라이언트의 과거 버전은 명령 줄 도구에만 해당 되었으므로이 새로운 사용자 인터페이스는 참조 값의 어트랙션을 확장해야하며 GPU 또는 NPU (또는 둘 다)에서 AI 타이어를 누르고 자하는 사용자 및 다른 하드웨어 및 소프트웨어 수에 대한 결과를 수집하고 비교 해야하는 전문 하드웨어 테스터를 위해 가끔 사용자를 위해 확장해야합니다.

MLPERF Client 1.0은 이제 GitHub의 모든 사람을위한 무료 다운로드로 제공됩니다. 광범위한 부하에서 시스템이 어떻게 작동하는지 이해하는 데 관심이 있으시면 제공하십시오. 우리는 버전 1.0과 함께 시간을 보냈으며 광범위한 하드웨어에서 AI의 성능을 탐색하면서 계속 파고 들게되어 기쁩니다.

따르다 Google 뉴스의 Tom의 하드웨어 우리의 피드에서 우리의 뉴스, 분석 및 리뷰를 얻기 위해. 다음 버튼을 클릭하십시오.